Il 19 luglio 2022, il comitato organizzatore della International Conference on Machine Learning (ICML) ha premiato il Prof. Battista Biggio (Università di Cagliari, co-founder di Pluribus One) e i suoi co-autori Blaine Nelson (Robust Intelligence, USA) e Pavel Laskov (University of Liechtenstein) con il prestigioso Test of Time Award per l’articolo scientifico "Poisoning Attacks Against Support Vector Machines", pubblicato 10 anni fa sugli atti della stessa conferenza, svoltasi a Edimburgo, nel 2012.

Il Premio

Il "Test of Time Award" è stato istituito nel 2010 e da allora riconosce gli articoli scientifici che hanno ottenuto il maggiore impatto sulla comunità scientifica nei dieci anni successivi alla loro presentazione ad ICML. Quest'anno, il premio è andato al Prof. Battista Biggio e ai suoi coautori per il loro articolo "Poisoning Attacks against Support Vector Machines", che è stato classificato come il più significativo su un totale di 244 articoli presentati alla conferenza ICML nel 2012, a Edimburgo. Prestigiosi i predecessori: gli autori si uniscono ai ricercatori dell'Università di Amsterdam, ETH Zurich, Harvard University, Amazon Research, INRIA, Facebook Research, Google Brain e DeepMind che hanno ricevuto il premio negli ultimi cinque anni.

Ecco la citazione della commissione di premiazione durante la consegna del premio, il 19 luglio a Baltimora, durante la conferenza ICML 2022 (foto in basso):

“Questo articolo riguarda la sicurezza del machine learning e delle tecniche di intelligenza artificiale (AI), che si è affermata come un'importante direzione di ricerca negli ultimi 10 anni. Gli attacchi di poisoning sono ora ampiamente studiati nel contesto della sicurezza del machine learning e dell’AI, e questo lavoro è uno dei primi articoli sul tema, nonché uno di quelli di maggior impatto sulla scena. L’articolo si concentra sugli attacchi di poisoning per le macchine a vettori di supporto (le cosiddette SVM, uno degli algoritmi più usati nel machine learning, ndr) e illustra anche come l’approccio può essere esteso ad altri algoritmi. Gli attacchi di poisoning sono stati dimostrati prima di questo articolo ma soltanto per semplici metodi di rilevamento delle anomalie e questo articolo ha stimolato un'indagine più approfondita del problema, ispirando un significativo numero di articoli scientifici successivi. Il lavoro è stato ampiamente studiato dalla comunità ed è particolarmente impressionante che la curva delle citazioni di questo articolo abbia continuato ad aumentare".

La conferenza ICML

La conferenza ICML è, insieme a NeurIPS, la conferenza principale su Machine learning ed Intelligenza Artificiale ed è rinomata a livello mondiale per la presentazione e la pubblicazione di ricerche all'avanguardia su tutti gli aspetti del machine learning utilizzati in aree strettamente correlate come l'intelligenza artificiale, la statistica e la scienza dei dati, come oltre a importanti aree di applicazione tra cui la visione artificiale, la biologia computazionale, il riconoscimento vocale e la robotica.

Il Prof. Battista Biggio ha tenuto una presentazione durante la cerimonia di premiazione per il Test of Time Award a Baltimora il 19 luglio 2022 (foto in basso), davanti a circa 1.000 partecipanti, raccontando la storia che ha portato alla stesura di questo lavoro scientifico e i principali sviluppi relativi ai 10 anni successivi.

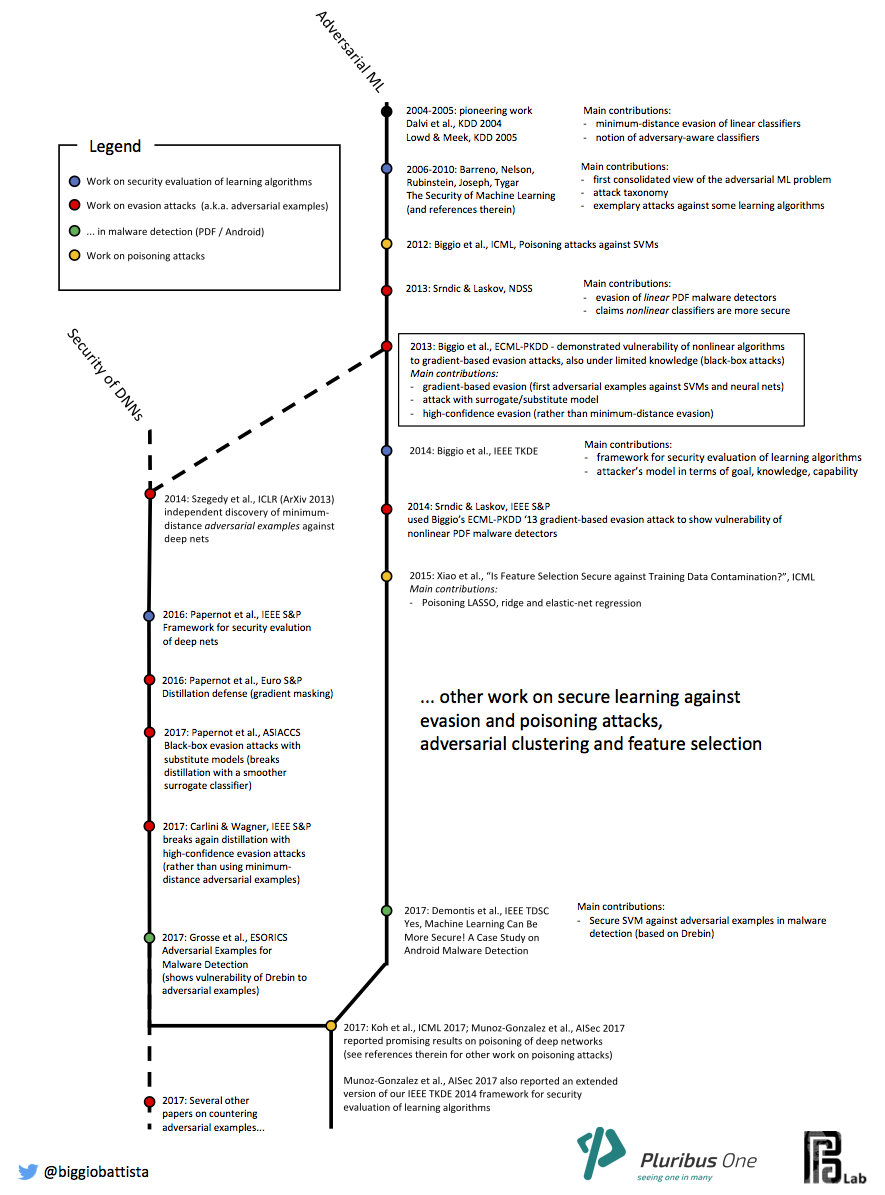

L’idea nasce nel 2011, quando Battista Biggio si trasferisce all’Università di Tubinga per un periodo di 6 mesi, per lavorare con Pavel Laskov e Blaine Nelson. L’idea dei ricercatori era quella di capire se gli algoritmi di machine learning usati nel contesto di applicazioni di sicurezza informatica fossero essi stessi vulnerabili ad attacchi in cui l’attaccante può manipolare anche soltanto una piccola porzione dei dati usati per addestrare il sistema. E il loro approccio ha dimostrato che, sotto determinate condizioni, l’attaccante può sostanzialmente inquinare l’intero processo di addestramento dell’algoritmo.

Nel 2013 gli stessi autori concepirono anche il primo attacco che potesse aggirare un modello già addestrato, ad esempio, per evadere i sistemi di rilevazione delle minacce informatiche basati su machine learning ed AI.

Nel 2014, lo stesso fenomeno è stato scoperto in modo indipendente in un altro articolo da ricercatori di Google, della New York University e dell'Università di Montreal e presentato come una "proprietà intrigante" delle reti neurali.

Da allora, più di 10.000 articoli sono apparsi su riviste e conferenze che esaminano la sicurezza dell'intelligenza artificiale.

Pioneers on Adversarial Machine Learning - Pionieri nell'Adversarial Machine Learning

- dimostrare che gli algoritmi di apprendimento automatico sono vulnerabili di fronte a manipolazioni basate sui gradienti dei dati di input, sia durante la fase di test (attacchi di evasione - evasion attacks) sia durante l'addestramento (attacchi di avvelenamento - poisoning attacks);

- configurare un quadro sistematico per la valutazione della sicurezza degli algoritmi di apprendimento;

- sviluppare contromisure adeguate per migliorare la loro sicurezza.

Interviste al nostro staff sulla sicurezza delle AI e del Machine Learning:

8 Luglio 2019: BBC News, AI pilot 'sees' runway and lands automatically

24 Aprile 2019: New Scientist, Machine mind hack: The new threat that could scupper the AI revolution

3 Marzo 2019: El Pais, La guerra de los robots: la salvación antes de la era ‘fake’

2 Febbraio 2019: The Register, Fool ML once, shame on you. Fool ML twice, shame on... the AI dev?

3 Gennaio 2019: Bloomberg News, Artificial Intelligence Vs. the Hackers

Cronologia

Vuoi approfondire il tema di ricerca di punta di Pluribus One?

Consulta la nostra sezione sulla Sicurezza del Machine Learning.

Vuoi provare Pluribus One Web Application Security®?

Il nostro staff ti risponderà al più presto per programmare una demo.