Wild Patterns

Tutorial sull'Adversarial Machine Learning

Secure ML: ricerca Tutorial: Wild Patterns Secure ML Library

Secure ML: ricerca Tutorial: Wild Patterns Secure ML Library

“Se conosci il nemico e conosci te stesso, non hai bisogno di temere il risultato di cento battaglie”

Sun Tzu, L'arte della guerra, 500 A.C.

Prossime edizioni del tutorial:

- Le prossime edizioni verranno annunciate appena possibile

Organizzatori e contatti:

- Battista Biggio, IAPR Member, IEEE Senior Member;

- Fabio Roli, IAPR Fellow, IEEE Fellow.

Pluribus One, e Università di Cagliari, Dipartimento di Ingegneria Elettrica ed Elettronica, Piazza d’armi 09123 Cagliari, Italia.

Abstract: WILD PATTERNS è il nostro tutorial di successo sulla sicurezza dei sistemi Machine Learning e di Intelligenza Artificiale, che ha visto negli ultimi anni la partecipazione complessiva di oltre 1000 partecipanti in tutto il mondo. WILD PATTERNS introduce le basi dell'apprendimento automatico in ambiente ostile (Adversarial Machine Learning), presentando tecniche recentemente proposte per valutare la vulnerabilità degli algoritmi di apprendimento automatico e alcune delle contromisure più efficaci. Nel tutorial consideriamo queste minacce in diversi domini applicativi (riconoscimento di oggetti all'interno di immagini, riconoscimento dell'identità biometrica, rilevazione di spam e malware).

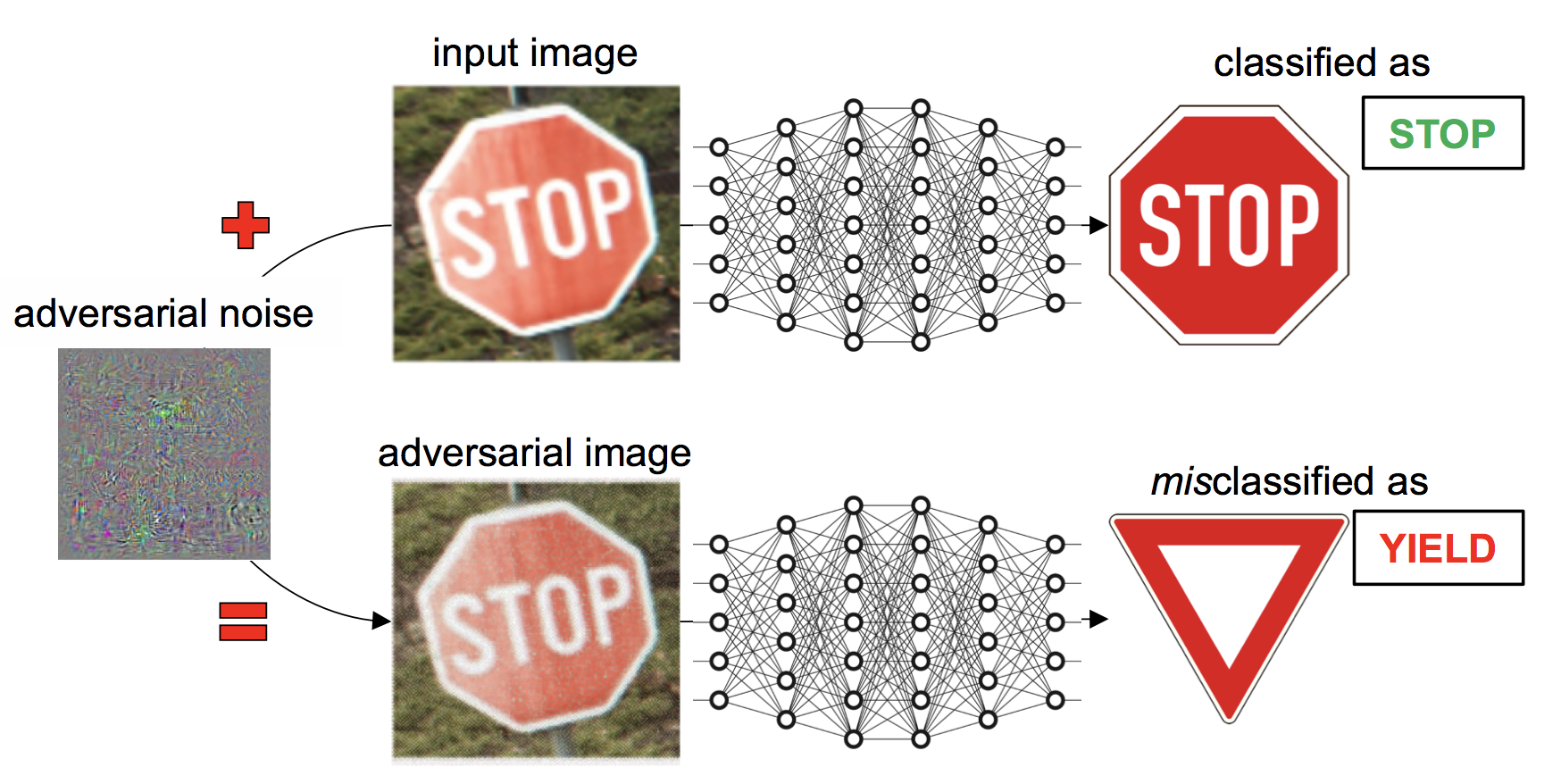

Descrizione del tutorial: le tecnologie di machine learning e di intelligenza artificiale, comprese le deep networks, sono attualmente utilizzate in diverse applicazioni, che vanno dalla visione artificiale alla sicurezza informatica. In alcune di queste applicazioni, tra cui la rilevazione di spam e malware, gli algoritmi di apprendimento devono affrontare attacchi intelligenti e adattivi che possono manipolare scrupolosamente i dati per sovvertire intenzionalmente il processo di apprendimento. Poiché questi algoritmi non sono stati originariamente progettati in ambienti "ostili" (cioè tenendo conto di tali possibilità di attacco), si sono dimostrati vulnerabili di fronte ad attacchi sofisticati e ben congegnati, tra cui gli attacchi evasivi (al momento del test) e gli attacchi contaminativi (in fase di addestramento), noti anche adversarial examples. Il contrasto a questo tipo di minacce informatiche e la creazione di sistemi sicuri e robusti di apprendimento automatico e intelligenza artificiale, sono quindi diventati oggetto di un campo di ricerca emergente correlato alla sicurezza del Machine Learning e dell'intelligenza artificiale: l'Adversarial Machine Learning.

Fig. 1. Esempio di manipolazione di un'immagine di input (inizialmente classificata correttamente come "segnale di stop" da una rete neurale profonda) in modo tale che risultasse erroneamente classificata come "segnale di precedenza". Il "rumore" manipolatore è ingrandito nell'immagine in alto, per favorirne la visibilità, ma rimane impercettibile all'occhio umano e nell'immagine manipolata risultante.

Finalità del tutorial:

- introdurre i concetti fondamentali dell'apprendimento automatico in ambiente ostile (Adversarial Machine Learning);

- illustrare il ciclo di progettazione degli algoritmi robusti di apprendimento automatico;

- presentare nuove tecniche, recentemente proposte, per valutare le prestazioni degli algoritmi di apprendimento sotto attacco, valutarne le vulnerabilità e implementare strategie di difesa che migliorino la robustezza agli attacchi;

- mostrare alcune applicazioni di Adversarial Machine Learning per il riconoscimento di oggetti all'interno di immagini, il riconoscimento dell'identità biometrica, la rilevazione di spam e malware

Sommario del tutorial

- Introduzione all'Adversarial Machine Learning. Introduzione attraverso esempi pratici, dalla computer vision alla biometria e alla rilevazione di spam e malware. Background sull'adversarial learning. Concetti e terminologia di base. Concetto di classificatore consapevole del nemico (adversary-aware). Definizioni di attacco e difesa.

- Progettazione di modelli di classificatori di modelli basati sull'apprendimento in ambienti ostili. Modellazione di compiti adversarial. Il modello a due giocatori (attaccante e classificatore). Livelli di conoscenza reciproca dei due giocatori (conoscenza perfetta, conoscenza limitata, conoscenza per queries e feedback). I concetti di security by design e security by obscurity.

- Progettazione di un sistema robusto: valutazione della vulnerabilità e strategie di difesa. Modelli di attacco contro i classificatori di pattern. L'influenza degli attacchi sul classificatore: attacchi causali ed esplorativi. Tipologie di violazione della sicurezza: attacchi all'integrità, alla disponibilità e alla privacy. Caratteristiche dell'attacco: attacchi mirati e attacchi indiscriminati. Valutazione della vulnerabilità mediante valutazione delle prestazioni. Tassonomia delle possibili strategie di difesa. Esempi dalla computer vision, dalla biometria, dalla rilevazione di spam e malware. Presentazione e utilizzo della Demo "Deep Learning security".

- Riepilogo e prospettive. Stato dell'arte attuale di questo campo di ricerca e prospettive future.

Pubblico e target del tutorial:

Questo tutorial introduce un argomento emergente ma vitale per l'intelligenza artificiale, ed è dedicato a:

Questo tutorial introduce un argomento emergente ma vitale per l'intelligenza artificiale, ed è dedicato a:

- studenti e lavoratori che desiderano apprendere le basi dell'Adversarial Machine Learing;

- ricercatori che lavorano sulla sicurezza di sistemi di Machine Learning, pattern recognition e intelligenza artificiale, che potrebbero avere componenti adversarial; ricercatori che desiderano apprendere come le tecniche di classificazione adversarial possano essere effettivamente utilizzate in tali sistemi.

Approfondimenti

- Biggio, B., Roli, F. Wild Patterns: Ten Years After the Rise of Adversarial Machine Learning. ArXiv, 2017. (articolo correlato al tutorial)

- Barreno, M., Nelson, B., Sears, R., Joseph, A. D., Tygar, J. D. Can machine learning be secure? ASIACCS, 2006.

- Huang, L., Joseph, A. D., Nelson, B., Rubinstein, B., Tygar, J. D. Adversarial machine learning. AISec, 2011.

- Biggio, B., Nelson, B., Laskov, P. Poisoning attacks against SVMs. ICML, 2012.

- Biggio, B., Corona, I., Maiorca, D., Nelson, B., Srndic, N., Laskov, P., Giacinto, G., Roli, F. Evasion attacks against machine learning at test time. ECML-PKDD, 2013.

- Biggio, B., Fumera, G., Roli, F. Security evaluation of pattern classifiers under attack. IEEE Trans. Knowl. Data Eng., 2014.

- Szegedy, C., Zaremba, W., Sutskever, I., Bruna, J., Erhan, D., Goodfellow, I., Fergus, R. Intriguing properties of neural networks. ICLR, 2014.

- Xiao, H., Biggio, B., Brown, G., Fumera, G., Eckert, C., Roli, F. Is feature selection secure against training data poisoning? ICML, 2015.

- Nguyen, A. M., Yosinski, J., Clune, J. Deep neural networks are easily fooled: High confidence predictions for unrecognizable images. CVPR, 2015.

- Goodfellow, I., Shlens, J., Szegedy, C. Explaining and harnessing adversarial examples. ICLR, 2015.

- Moosavi-Dezfooli, S.-M., Fawzi, A., Frossard, P. Deepfool: a simple and accurate method to fool deep neural networks. CVPR, 2016.

- Papernot, N., McDaniel, P., Jha, S., Fredrikson, M., Celik, Z. B., Swami, A. The limitations of deep learning in adversarial settings. IEEE Euro S&P, 2016.

- Papernot, N., McDaniel, P., Goodfellow, I., Jha, S. Celik, Z. B., Swami, A. Practical black-box attacks against machine learning. ASIACCS, 2017.

- Carlini N., Wagner, D. Towards evaluating the robustness of neural networks. IEEE Symp. SP, 2017.

- Demontis, A., Melis, M., Biggio, B., Maiorca, D., Arp, D., Rieck, K., Corona, I., Giacinto, G., Roli, F. Yes, machine learning can be more secure! a case study on Android malware detection. IEEE Trans. Dependable and Secure Comp., 2017.

- Melis, M., Demontis, A., Biggio, B., Brown, G., Fumera, G., Roli, F. Is deep learning safe for robot vision? Adversarial examples against the iCub humanoid. In ICCV Workshop ViPAR, 2017.

- Athalye, A., Carlini, N., Wagner, D. Obfuscated Gradients Give a False Sense of Security: Circumventing Defenses to Adversarial Examples. ArXiv, 2018.

- Athalye, A., Engstrom, L., Ilyas, A., Kwok, K. Synthesizing robust adversarial examples. ICLR, 2018.

- Jagielski, M., Oprea, A., Biggio, B., Liu, C., Nita-Rotaru, C., Li, B. Manipulating machine learning: Poisoning attacks and countermeasures for regression learning. IEEE Symp. SP, 2018.

Relatori

Battista Biggio è Assistant Professor presso l'Università di Cagliari, Italy, e AI Chief Scientist di Pluribus One, società che ha co-fondato nel 2015. Pluribus One è una spin-off del Pattern Recognition and Applications laboratory, che sviluppa tecnologie di machine learning per applicazioni di visione artificiale e di sicurezza informatica.

Battista Biggio è Assistant Professor presso l'Università di Cagliari, Italy, e AI Chief Scientist di Pluribus One, società che ha co-fondato nel 2015. Pluribus One è una spin-off del Pattern Recognition and Applications laboratory, che sviluppa tecnologie di machine learning per applicazioni di visione artificiale e di sicurezza informatica.Ha dedicato più di dieci anni di ricerca su questioni teoriche e metodologiche nell'area del machine learning e del pattern recognition per risolvere problemi in concrete applicazioni di computer vision e sicurezza informatica. Ha fornito contributi significativi al settore dell'Adversarial Machine Learning, ricoprendo un ruolo di primo piano nella creazione e nella promozione di questo campo di ricerca. Battista Biggio ha pubblicato più di 60 articoli su questi argomenti di ricerca e molti dei suoi articoli sono citati frequentemente. Negli ultimi anni, è stato invitato a tenere diverse presentazioni e conferenze sull'Adversarial Machine Learning. Il suo h-index è pari a 24 (aprile 2018), e i suoi articoli hanno raccolto oltre 1.850 citazioni (dati Google Scholar). È Senior Member dell'IEEE, IAPR Member, Chairman del IAPR Technical Committee on Statistical Pattern Recognition Techniques, e Associate Editor di Pattern Recognition e di IEEE Transactions on Neural Networks and Learning Systems.

Fabio Roli è professore ordinario di Ingegneria Informatica presso l'Università di Cagliari; è inoltre direttore e fondatore del laboratorio universitario Pattern Recognition and Applications laboratory, che, nato nel 1995, si è affermato a livello mondiale e conta oggi più di 30 membri (di cui 5 di ruolo). È manager dei progetti R&D della società Pluribus One, di cui è co-fondatore. Ha dedicato più di 30 anni di vita professionale nella ricerca volta alla progettazione di sistemi di pattern recognition. Il Prof. Roli ha pubblicato 81 articoli e più di 250 conference proceedings nel campo del pattern recognition e del machine learning e molte delle sue pubblicazioni sono citate frequentemente. Il suo attuale h-index è 56 secondo Google Scholar (aprile 2018), e i suoi articoli sono stati citati più di 11.000 volte. È stato nominato IEEE Fellow e IAPR Fellow. È stato presidente del Gruppo Italiano di Ricercatori in Pattern Recognition (GIRPR) e Chairman del IAPR Technical Committee on Statistical Techniques in Pattern Recognition. È stato membro del NATO advisory panel for Information and Communications Security, NATO Science for Peace and Security (2008 – 2011). Il Prof. Roli è uno dei pionieri dell'utilizzo del pattern recognition e del machine learning per la sicurezza informatica. È spesso invitato a tenere presentazioni e tutorial sull'Adversarial Machine Learning per applicazioni di sicurezza. È (ed è stato) il Principal Investigator di decine di progetti di ricerca e sviluppo, compresi i progetti Europei CyberRoad e ILLBuster.

Fabio Roli è professore ordinario di Ingegneria Informatica presso l'Università di Cagliari; è inoltre direttore e fondatore del laboratorio universitario Pattern Recognition and Applications laboratory, che, nato nel 1995, si è affermato a livello mondiale e conta oggi più di 30 membri (di cui 5 di ruolo). È manager dei progetti R&D della società Pluribus One, di cui è co-fondatore. Ha dedicato più di 30 anni di vita professionale nella ricerca volta alla progettazione di sistemi di pattern recognition. Il Prof. Roli ha pubblicato 81 articoli e più di 250 conference proceedings nel campo del pattern recognition e del machine learning e molte delle sue pubblicazioni sono citate frequentemente. Il suo attuale h-index è 56 secondo Google Scholar (aprile 2018), e i suoi articoli sono stati citati più di 11.000 volte. È stato nominato IEEE Fellow e IAPR Fellow. È stato presidente del Gruppo Italiano di Ricercatori in Pattern Recognition (GIRPR) e Chairman del IAPR Technical Committee on Statistical Techniques in Pattern Recognition. È stato membro del NATO advisory panel for Information and Communications Security, NATO Science for Peace and Security (2008 – 2011). Il Prof. Roli è uno dei pionieri dell'utilizzo del pattern recognition e del machine learning per la sicurezza informatica. È spesso invitato a tenere presentazioni e tutorial sull'Adversarial Machine Learning per applicazioni di sicurezza. È (ed è stato) il Principal Investigator di decine di progetti di ricerca e sviluppo, compresi i progetti Europei CyberRoad e ILLBuster.